近期,麻省理工學院(MIT)的一支科研團隊帶來了機器人技術領域的重大進展。他們開發出一種創新的深度學習策略,使得軟體機器人和仿生機器人僅通過單個攝像頭便能學習并控制自身的運動。

這一突破性技術成果已于6月25日在《自然》雜志上正式發表,其有望大幅度削減機器人研發的成本。

傳統工業機器人雖然便于建模與控制,但其剛性的構造在狹窄或復雜地形中顯得力不從心。軟體及仿生機器人盡管在環境適應性上具有顯著優勢,卻常常需要依賴大量的傳感器以及定制化的空間模型。

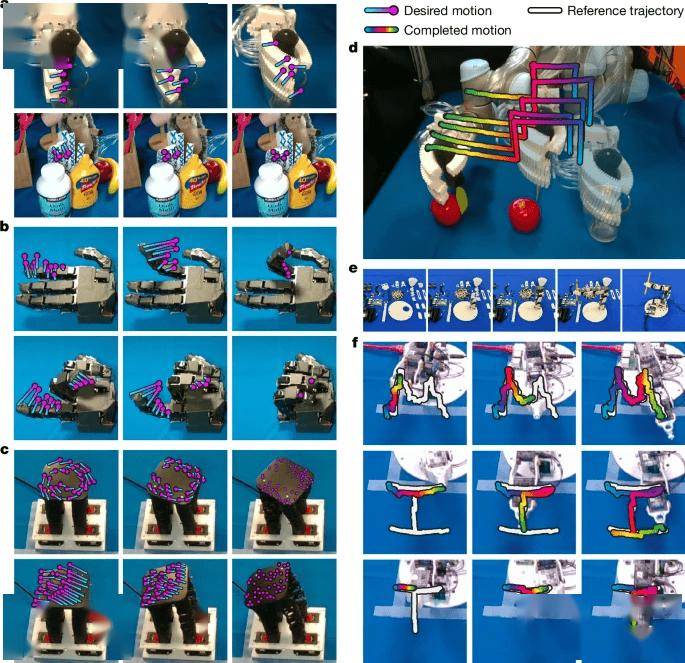

MIT的研究團隊巧妙地運用深度學習技術,成功解決了這一難題。他們設計的新系統僅依靠單個攝像頭捕捉機器人的運動圖像,并結合“神經雅可比場(NJF)”技術,讓機器人能夠借助視覺反饋來建立對自身形態及運動能力的認知。

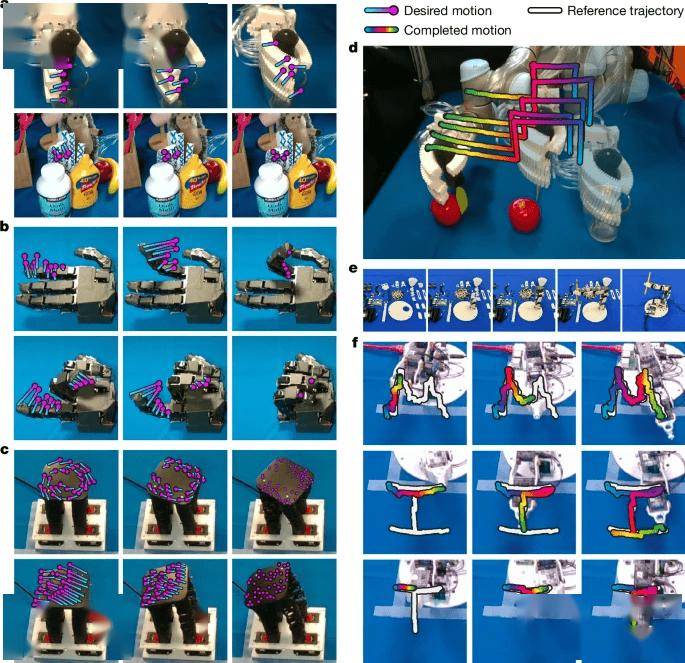

在實驗中,研究團隊對多種類型的機器人進行了2至3小時的多視角隨機運動視頻訓練。這一訓練使得神經網絡能夠通過單幀圖像重建出機器人的三維形態及運動范圍。

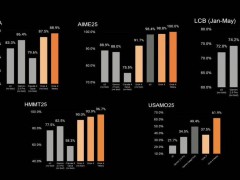

經過測試,包括氣動軟體機械手、奧利格羅機械手(擁有16個自由度)、3D打印機械臂以及低成本的Poppy機械臂在內的多種機器人,均展現出了卓越的性能:關節運動誤差小于3度,指尖控制誤差小于4毫米,并且能夠適應環境的動態變化。

MIT的助理教授文森特·西茨曼(Vincent Sitzmann)指出:“視覺作為一種靈活的傳感器,為非結構化環境(如農場、工地等)中的機器人應用開辟了新的可能性。”

CSAIL的主任丹妮拉·羅斯(Daniela Rus)補充道:“視覺反饋讓系統能夠建立起自身運動動力學的內部模型,從而在傳統定位方法失效的場景中實現自我監督操作。”