螞蟻集團旗下的百靈大模型團隊在近期舉辦的螞蟻技術(shù)日上宣布了一項重要決定:將統(tǒng)一多模態(tài)大模型Ming-lite-omni進行開源。這一舉動標志著螞蟻集團在人工智能領(lǐng)域的又一次重大開放。

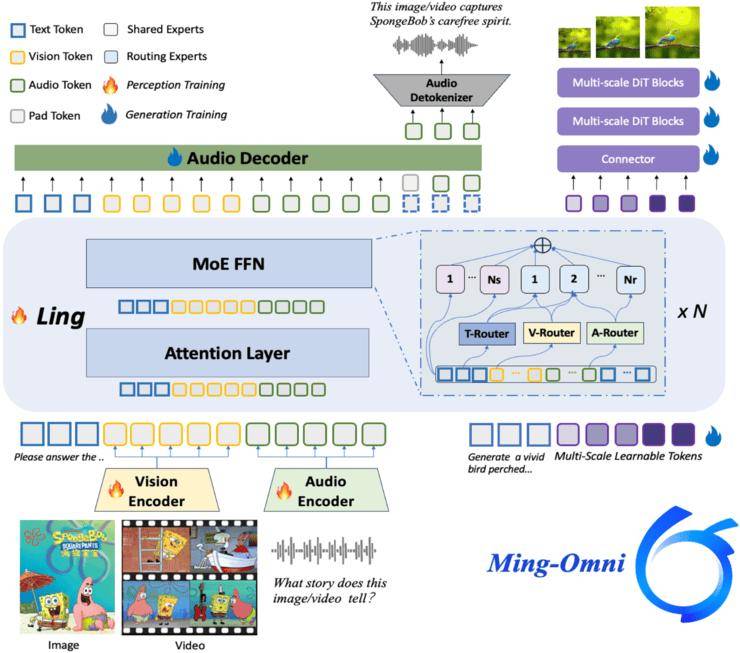

Ming-lite-omni是基于Ling-lite構(gòu)建的MoE架構(gòu)全模態(tài)模型,擁有220億的總參數(shù)和30億的激活參數(shù)。據(jù)螞蟻集團介紹,該模型不僅在技術(shù)上實現(xiàn)了突破,更在參數(shù)規(guī)模上達到了新的高度。

目前,Ming-lite-omni的模型權(quán)重和推理代碼已經(jīng)面向公眾開放,后續(xù)訓練代碼和訓練數(shù)據(jù)也將陸續(xù)推出。這一舉措無疑將推動人工智能領(lǐng)域的技術(shù)創(chuàng)新和應用發(fā)展。

今年以來,百靈大模型團隊已經(jīng)連續(xù)開源了多個模型產(chǎn)品,包括Ling-lite、Ling-plus等大語言模型,以及多模態(tài)大模型Ming-lite-uni和預覽版的Ming-lite-omni。這些開源模型不僅豐富了人工智能領(lǐng)域的技術(shù)生態(tài),更為開發(fā)者提供了更多的選擇和可能性。

據(jù)百靈大模型團隊介紹,五月中旬開源的Ling-lite-1.5版本在能力上已經(jīng)接近同水位的SOTA水平,介于千問4B和8B之間。這一成就不僅驗證了300B尺寸的SOTA MoE大語言模型在非高端算力平臺上訓練的可行性,更展示了國產(chǎn)GPU在人工智能領(lǐng)域的潛力。

而本次開源的Ming-lite-omni在多項理解和生成能力評測中,性能與10B量級領(lǐng)先的多模態(tài)大模型相當或更優(yōu)。螞蟻集團認為,這是目前已知首個在模態(tài)支持方面能夠與GPT-4o相媲美的開源模型。這一成就不僅彰顯了螞蟻集團在人工智能領(lǐng)域的技術(shù)實力,更為全球開發(fā)者提供了更多的選擇和參考。

百靈大模型負責人西亭表示,百靈大模型的命名規(guī)則中,Ling代表基礎(chǔ)大模型,Ring代表推理版本,Ming則代表多模態(tài)大模型。在過去的時間里,百靈大模型團隊主要在MoE架構(gòu)和多模態(tài)領(lǐng)域進行了深入探索。他們堅定地在語言大模型和多模態(tài)大模型上統(tǒng)一使用了MoE架構(gòu),并使用了大量非高端的算力平臺,成功證明了國產(chǎn)GPU在訓練可比擬GPT4o模型方面的能力。

對于未來的規(guī)劃,百靈大模型團隊表示將持續(xù)優(yōu)化Ming-lite-omni在全模態(tài)理解和生成任務上的效果,并提升其多模復雜推理能力。同時,他們還將訓練更大尺寸的全模態(tài)模型Ming-plus-omni。根據(jù)西亭透露,百靈還在籌備Ling的Max版本,發(fā)布時間將與deepseek V3的版本相近。