阿里巴巴通義實驗室近期宣布了一項重大開源成果——音頻生成模型ThinkSound,這一創新之舉標志著AI在音頻創作領域邁出了重要一步。ThinkSound的獨特之處在于,它首次引入了CoT(思維鏈)技術,使AI能夠模擬專業音效師的思考過程,精準捕捉視覺細節,并生成與畫面完美同步的高保真音頻。

據悉,ThinkSound的代碼和模型已在Github、HuggingFace及魔搭社區等平臺全面開源,供開發者免費下載和體驗。這一開放舉措無疑將極大地推動音頻生成技術的發展,激發更多創新應用。

在多媒體編輯和視頻內容創作領域,視頻生成音頻(V2A)技術一直備受關注。然而,現有技術往往難以準確捕捉畫面中的動態細節和時序信息,導致生成的音頻與關鍵視覺事件錯位,無法滿足專業創意場景的高要求。針對這一難題,通義實驗室將思維鏈推理引入多模態大模型,實現了對視覺事件與聲音之間深度關聯的精準建模。

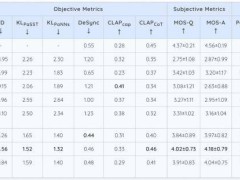

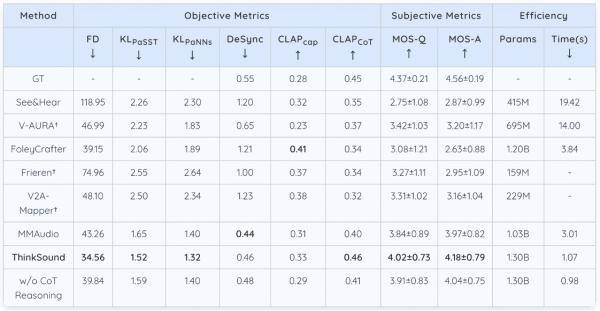

為了進一步提升模型的性能,通義團隊還構建了首個帶思維鏈標注的音頻數據集AudioCoT。該數據集融合了超過2500小時的多源異構數據,為模型在音頻生成與編輯任務中提供了豐富的訓練素材。得益于此,ThinkSound在開源的VGGSound測試集上表現優異,多項核心指標均超越了現有主流方法。

具體而言,在openl3空間中Fréchet 距離(FD)這一指標上,ThinkSound相比MMAudio降低了近9個點,接近真實音頻分布的相似度提高了20%以上。同時,在代表模型對聲音事件類別和特征判別精準度的KLPaSST 和 KLPaNNs兩項指標上,ThinkSound也取得了同類模型中的最佳成績。

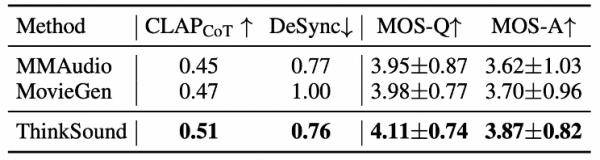

在MovieGen Audio Bench測試集上,ThinkSound同樣展現出了強大的實力,大幅領先于meta推出的音頻生成模型Movie Gen Audio。這一表現不僅證明了ThinkSound在影視音效、音頻后期等領域的廣泛應用潛力,也為其在游戲與虛擬現實音效生成等前沿領域的應用奠定了堅實基礎。

通義實驗室在音頻生成領域的布局遠不止于此。此前,該實驗室已推出語音生成大模型Cosyvoice和端到端音頻多模態大模型MinMo等,全面覆蓋了語音合成、音頻生成、音頻理解等多個場景。此次ThinkSound的開源,無疑將進一步鞏固通義實驗室在音頻生成領域的領先地位。